サルドラさんのAituberの本 を購入して以来

自分でもAituber動かしたいなーって思いながら、

Grokのコンパニオンモード、Aniちゃんの登場で俄然Aituberが、身近なものになったのがつい先々月、先月の話でしたが。(世の中のスピード早すぎだろ。。。)

私も、Live2D Model を使って、AITuberをコツコツつくっていたんですが、ふと「海外でこのあたりのAituberの環境が、もうオープンソースになっていたりしてっ」

て調べてみたら、予感的中で、何と台湾出身のアメリカの学生さんが、物凄いAItuberの環境構築ツールを作成していたんです。。。

オープンソースで公開していたので、さっそくクローン

いろいろと試行錯誤してようやく安定的に動作させることができてきたので、少し調整した版を安定板として、Open-LLM-Vtuberの手順書をつくってみましたー。

是非夏休みにAITuberの制作に取り組んでみてはいかがでしょうか。(ハマるとかなりの時間を割いてしまうのでそこは自己責任で。。。)笑

- 0) 前提

- 1) 基本セットアップ(WSL / Ubuntu)

- 2) uv をインストール(依存を自動解決する実行ツール)

- 3) リポジトリ取得とブランチ切替

- 4) uv で依存関係をそろえる(Python 3.10 を強制)

- 5)音声認識モデルの導入(推奨構成)

- ローカルにLLMをインストールしてAITuberを動かしたい方(ハイスペックPC推奨(GPU搭載機など)) ※OPENAI API / Gemini API を使用する方はスキップしてください。

- 6-1) Ollama を導入(ローカルLLM)

- 6-2) conf.yaml の最小編集(Ollama接続 & 日本語TTS)

- ChatGPT(OPEN API LLM / Gemini )など、LLMを使用して AItuberを動作させたい方(ロースペックPCでも快適に動作するので推奨)

- 7)AITuberサーバ起動

0) 前提

Windows 11 + WSL2(Ubuntu 22.04 以上)

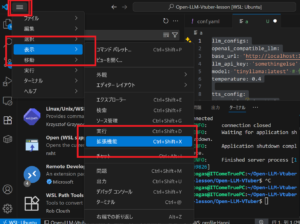

VS Code(WSL拡張)

WSLのインストールとVSCodeのインストールは

こちらの記事で紹介しましたのでご参照ください。

1) 基本セットアップ(WSL / Ubuntu)

#以下を順番に入力実行していく。

#① APT 更新と最低限のビルド環境

sudo apt update && sudo apt -y upgrade

#② curlなど必要なものをインストール

sudo apt -y install build-essential curl pkg-config# ③Gitをインストール

sudo apt -y install git

# ④Python 3.10 系(WSLのUbuntu 22.04なら3.10が標準)をインストール

sudo apt -y install python3.10 python3.10-venv python3.10-dev

# ⑤FFmpeg(音声・動画処理)

sudo apt -y install ffmpeg

# ⑥音声系でハマりにくくなるやつ

sudo apt -y install libsndfile1 portaudio19-dev

2) uv をインストール(依存を自動解決する実行ツール)

# uv をインストール

curl -LsSf https://astral.sh/uv/install.sh | sh

# PATH を通す

echo ‘export PATH=”$HOME/.local/bin:$PATH”‘ >> ~/.bashrc

source ~/.bashrc

# 動作確認

uv --version

3) リポジトリ取得とブランチ切替

#Github に本家からForkさせていただきました。本当に素晴らしいOPENソースなのでぜひ、本家の方ものぞいてみてください。こちらのFork版は、すぐにローカルで動作するところで微調整した状態にしてあります。

# ①まずは、Gitからダウンロードしてくるフォルダを作成

cd ~

mkdir 〇〇 (例 open-llm-vtuber )

#②Open-llm-VtuberのFork版をクローンcd ~/open-llm-vtuber

git clone https://github.com/togashira/Open-LLM-VTuber.git open-llm-vtuber

cd #④念の為 originをfetch

git fetch origin

#⑤念の為 after branchにチェックアウト

git checkout -b after origin/after

4) uv で依存関係をそろえる(Python 3.10 を強制)

# 依存を同期(pyprojectがあれば自動解決)

uv sync --python 3.10

5)音声認識モデルの導入(推奨構成)

# ①Gitからクローンした、プロジェクトのルートディレクトリへ

cd ~/〇〇/Open-LLM-VTuber

# ②Hugging Faceというサービス から SenseVoice モデルをクローンして取得

git clone https://huggingface.co/csukuangfj/sherpa-onnx-sense-voice-zh-en-ja-ko-yue-2024-07-17

# ③クローンしたフォルダに移動

cd sherpa-onnx-sense-voice-zh-en-ja-ko-yue-2024-07-17

# ④モデルファイルを Pull

git lfs pull

ローカルにLLMをインストールしてAITuberを動かしたい方(ハイスペックPC推奨(GPU搭載機など)) ※OPENAI API / Gemini API を使用する方はスキップしてください。

6-1) Ollama を導入(ローカルLLM)

WSLで systemd 未有効なら「serve 直起動」を使うのが簡単。

# ①インストール

curl -fsSL https://ollama.com/install.sh | sh

# ②言語モデル取得( phi3:mini)

ollama pull phi3:mini

# ③言語モデルを選択

ollama pull phi3:mini

# ④別ターミナルでサーバを起動(systemdが無い場合)

ollama serve

# ⑤動作確認curl -s http://127.0.0.1:11434/api/tags

6-2) conf.yaml の最小編集(Ollama接続 & 日本語TTS)

プロジェクト直下の conf.yaml で ここだけ 揃えると安定:

すでに Ollama で

phi3:miniを使うなら、model: 'phi3:mini'に統一。

ChatGPT(OPEN API LLM / Gemini )など、LLMを使用して AItuberを動作させたい方(ロースペックPCでも快適に動作するので推奨)

OpenAI APIを使用するケース

7)AITuberサーバ起動

# ①ここまで準備ができましたら、いよいよサーバ起動です。

uv run run_server.py

#② 実行の様子

togas@ITComeTruePC:~/open-llm-vtuber/Open-LLM-VTuber$ uv run run_server.py

2025-08-09 20:27:52.268 | INFO | __main__:<module>:86 – Running in standard mode. For detailed debug logs, use: uv run run_server.py –verbose

2025-08-09 20:27:52 | INFO | __main__:run:57 | Open-LLM-VTuber, version v1.1.4

・

・

・

2025-08-09 20:28:15 | INFO | src.open_llm_vtuber.agent.agents.basic_memory_agent:__init__:66 | BasicMemoryAgent initialized.

INFO: Started server process [152970]

INFO: Waiting for application startup.

INFO: Application startup complete.

INFO: Uvicorn running on http://localhost:12393 (Press CTRL+C to quit)

INFO: (‘127.0.0.1’, 60966) – “WebSocket /client-ws” [accepted]

INFO: connection open

# ② ここまで来たらあと少し、ブラウザに以下のアドレスを入力して動作確認しよう。

http://localhost:12393/

コメント